Kurš pieņem lēmumu?

Mākslīgā intelekta lēmumu pieņemšana ir algoritma loģika un tajā pašā laikā mīkla, radot ētiskus un atbildīgus lēmumus. MI ētiskie jautājumi ir neierobežoti, un ir virkne gadījumu, kad tiek pārkāpti morāles principi, kurus pat labākais no mums nespēj atrisināt.

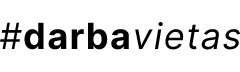

Kā MI robots rīkotos, ja tiek apdraudēta cilvēka dzīvība, privātums vai cilvēka cieņa? Cilvēki bieži uzdod man jautājumus: "Jūs esat MI pētnieks, pastāstiet mums, kuru robots izvēlētos glābt autoavārijā – bērnu vai vecmāmiņu?", "Tas glābtu gājēju vai automašīnas vadītāju?" vai "Ko darītu MI ugunsgrēka gadījumā – dzēstu liesmas, lai paglābtu īpašumu, vai glābtu cilvēku no liesmām?"

Ētiskās sadursmes šeit ir diezgan acīmredzamas: tu veido loģisko ķēdi un atrisini ētisko mīklu. Tu nevēlies iegādāties automatizētu automašīnu, kurai prioritāte negadījuma laikā nav tavas dzīvības glābšana. Tomēr ir nianses, un pats jautājums ir nepareizs. Un es izstāstīšu, kāpēc.

Iedomājies, ka esi ārsts un ārstē pacientus, kuri cieš no milzīgām galvassāpēm. Tu viņiem iedod zāles, kas noņem sāpes, tomēr pacienti turpina atkal un atkal atgriezties ar to pašu diagnozi. Kas šeit nav pareizi? Ārsts novērsa sāpes, bet neizārstēja slimības galveno cēloni. Tieši tāda pati situācija ir šeit: "sāpju noņemšana" šajā scenārijā būs lēmumu pieņemšanas algoritms, tomēr "root cause" (cēlonis, problēmas sakne) slēpjas ētikas prasībās, kad divas pretrunīgi vērtētas prasības netiek pareizi noteiktas un novertētas.

Tāds pats ir stāsts ar MI bezpilota lidaparātu, kas kā mērķi uzbrukumam noteica cilvēkus. Kļūda nenotiktu, ja bezpilota lidaparātu ražotāji to būtu izveidojuši par atbildīgu MI. Atbildīgais MI ir pārvaldības sistēma, kas risina ar mākslīgo intelektu saistītas problēmas gan no ētikas, gan juridiskā viedokļa. Mans jaunākais maģistra darba pētījums piedāvāja praktisku pamatu tam, kā novērtēt katras ētikas prasības un pēc tam noteikt tās pēc prioritātes izstrādātājiem.

Filozofe un "AI Ethics Lab" dibinātāja un direktore Džansu Džandza (Cansu Canca) skaidro, kā mēs efektīvāk varam tikt galā ar ētikas riskiem, ja mēs tiem pieejam kā mīklai un atrisinām tos, izmantojot lietišķās filozofijas rīkus.

Kā izveidot atbildīgu MI?

Lai izveidotu atbildīgu MI, jāsāk no ētikas prasībām un, ja tev tās jau ir zināmas, ir nepieciešama to novērtēšana. Iedomājies, tev būs jānosaka prioritātes, jāizvērtē, kura prasība ir vairāk, kura mazāk svarīga, kā arī jānoņem tās prasības, kas nesakrīt ar ētikas normām. Bez atbilstoša "framework" jeb vadlīnijām, izvērtēšana un prioritizēšana var kļūt par haosu.

Savā maģistrā darbā es izanalizēju visu pieejamo informāciju par šo tēmu un nonācu pie secinājuma – neskatoties uz to, ka šī tēma IT industrijā ir akūta, lielākā daļa no pētījumiem apspriež ētikas principus mākslīgā intelekta jomā teorētiski. Man radās ideja izveidot vadlīnijas, kuras būtu iespējams izmantot industrijā, lai izstrādātu programmatūru ar MI risinājumiem, kas ņem vērā ētikas principus.

Tas nebija viegli, bet gala rezultātā nonācu pie savām vadlīnijām, kuras veiksmīgi integrēju, izmantojot datus no diviem IT projektiem, un pierādīju, kā izveidotās vadlīnijas var būt efektīvi izmantotas, lai noteiktu ētikas prasības pret "gudrajām" programmatūrām/ierīcēm, kā arī identificēju iespējas tālāku vadlīniju attīstībai.

Kā man veicās pētniecībā?

Pētījuma laikā es iedziļinājos MI ētikas vēsturē, likumos un dažādos starptautiskos noteikumos. Tā ir pavisam cita, atvērta pasaule domāšanai un radīšanai! Vai zināji, ka Eiropā ir Eiropas Mākslīgā intelekta koordinācijas komiteja, kas izveidota 1982. gadā? Starp citu, arī Latvija tur aktīvi iesaistās. Šīs komitejas ieskatā uzņēmumi, kas nodarbojas vai pielieto ētisko MI, var pilnībā izmantot MI risinājumu priekšrocības tikai tad, ja tiem pilnībā uzticas. Šajā brīdī es arī atklāju piecus galvenos MI principus, kuri ir zināmi arī kā bioētikas principi: labvēlība, ne-ļaunprātība, taisnīgums (izturies pret citiem taisnīgi), pārredzamība un autonomija (cieņa pret cilvēku), kas veido medicīnas ētikas principus.

Viena no pārsteidzošākajām lietām pētniecības procesā bija gadījumu izpēte. Es izvēlējos divus ļoti svarīgus MI nozares uzņēmumus: "Accenture" (Īrija) un "Alpha Health" (Spānija). "Accenture" ir līderis atbildīgā MI koncepcijas popularizēšanā, savukārt "Alpha Health" ir ļoti stingra ētikas politika to MI veselības lietojumprogrammām, kas viņus padara par vienu no atbildīgākajiem medicīnas uzņēmumiem, kas īsteno MI risinājumus. Pētījuma rezultāti parādīja, ka MI ir milzīgs potenciāls abās nozarēs, proti, veselības aprūpē un uz MI balstītu lēmumu pieņemšanā. Ētikas nepieciešamībai mākslīgā intelekta jomā pēdējā laikā ir pievērsta ļoti liela uzmanība. Šodien daudziem uzņēmumam vairs nepietiek tikai ar programmatūras ražošanu – bez ētikas nebūs uzticēšanās, un bez uzticēšanās lietojumprogrammas var gan nodarīt kaitējumu indivīdam vai sabiedrībai.

Diemžēl ne visiem uzņēmumiem rūp ētika, kā to pielieto "Accenture" vai "Apha Health". Citos uzņēmumos ir bijuši ļaunprātīgi gadījumi, piemēram, uzņēmums, kas ražoja fitnesa aprīkojumu un apstrādāja biometriskos datus, pēc tam tos izmantoja savtīgās interesēs. Pateicoties Eiropas Savienībai, tavs privātums ir aizsargāts no likuma puses. Likumdevēji jau ir paveikuši daudz darba, lai nodrošinātu, ka uzņēmumi ar lielu atbildību izstrādā savu augstākā līmeņa risinājumu.

Atklāti sakot, visinteresantākā pētījuma daļa bija ētikas ietvara izstrāde un tā aprobācija. Apkopojot informāciju pa mazai daļiņai – literatūras apskatus un gadījumu izpētes –, man izdevās izstrādāt divu fāžu vadlīnijas. Protams, tas bija grūts darbs, kas prasīja daudz laika un lielu centību. Tomēr pēc mēneša ilga darba gatava shēma bija uz mana galda, un es turpināju ar patīkamo daļu – vadlīniju aprobāciju, lai pierādītu, ka tas patiešām darbojas. Noteikti zini, kā cilvēki dažreiz piegādā zinātniskus produktus – kādam ir pārsteidzoša ideja, bet bez prakses tā vērtība samazinās gandrīz līdz nullei. Aprobācijas procesa laikā es atcerējos savu aizraušanos ar žurnālistiku un ņēmu piemēru no žurnālista, kas palīdz ziņu aģentūras "Associated Press" redakcijai dažādos uzdevumos saistībā ar MI robotiem. Vismaz atradu informāciju un risinājumus, ko es varētu izmantot no interneta avotiem.

Soli pa solim es identificēju ētiskās prasības MI robotam-žurnālistam: tā ir kā puzle, mīkla. Daudz prasību 20 dažādās kategorijās. Tās visas apkopoju un apstrādāju caur izvirzītajām vadlīnijām. Riska pārvaldība un riska novērtēšanas prasmes arī ir ļoti vajadzīgas procesa laikā! Rezultātā es ieguvu matricu ar galvenajām prasībām. Katrai prasībai bija sava vērtība, kas ieņēma konkrētu vietu izveidotajā matricā. Programmas izstrādātājam kādā uzņēmumā šāda matrica palīdzēs izveidot atbildīgu MI robotu-žurnālistu, kuram uzticēsies redakcijas un laikrakstu lasītāji. Es sapņoju par šāda robota izgatavošanu savam nekomerciālajam mediju projektam, un tagad man tam ir pamats!

Tā tas darbojas: pacietība, smags darbs, apņēmība ir tavs labākais draugs turpmākajos pētījumos!

Pēdējais, bet ne sliktākais

Varbūt esi dzirdēji daudz sazvērestības teorijas no MI skeptiķiem, ka "ļaunais MI iznīcina cilvēci, dodot priekšroku glābt Zemi no cilvēkiem". Mans personīgais viedoklis: aizmirstiet par visām šīm teorijām un koncentrējieties uz zinātni – cilvēces iznīcināšana no MI puses nenotiks, jo prioritāri tas izvēlēsies glābt cilvēku. Kāpēc? Superintelekta, kura pamatā ir atbildīga MI sistēma, visa loģika atbilst morāles un ētikas normām, un uzticība ir kā galvenais mērķis.

Kā teicis Leonardo Da Vinči: "Visas mūsu zināšanas ir mūsu priekšstatu pamatā." Ja ir labāka pasaule, kuru mēs varam izveidot, vai mēs spēsim to pārvaldīt? Mana atbilde ir: "Jā, mēs spēsim, izmantojot atbildīgo MI struktūru."

"Alekseja (attēlā) maģistra darbs šogad bija labākais studiju programmā "Informācijas sistēmu vadība". Darbs tika veltīts mākslīgā intelekta ētikas jautājumu pielietošanai no programmatūras un informācijas sistēmas izstrādātāja viedokļa. Jāatzīmē, ka mākslīgā intelekta pielietošana un ētiskie jautājumi ir vieni no aktuālākajiem jautājumiem IT industrijā," tā par Alekseja Vesjolija maģistra darbu saka TSI prorektors akadēmiskajā un zinātniskajā darbā asociētais profesors, Dr. sc. ing. Mihails Savrasovs.